Поисковая оптимизация

Что надо знать заказчику про поисковую оптимизацию сайта?

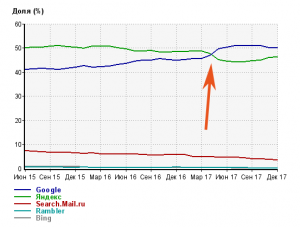

Цель поисковой оптимизации – переходы с поисковых систем. Доля поискового трафика в Рунете по данным LiveInternet. Стрелочкой отмечена смена лидера в 2017 году.

Технические тонкости оставим специалистам, а здесь рассмотрим самые важные моменты, которые должен понимать каждый владелец сайта.

Итак, определение:

Поисковая оптимизация (англ. search engine optimization, SEO) – работа по увеличению целевого трафика с поисковых систем за счет улучшения позиций сайта в поисковой выдаче.

Обращаю внимание на детали в этом определении:

- Речь идет о целевых посетителях.

- Речь идет о трафике с поисковых систем, а не о самих позициях сайта в выдаче.

- Речь идет именно о поисковом трафике, а не о трафике с поисковых систем за счет контекстной и другой рекламы, размещаемой на поисковых системах.

- Ну и обратите внимание на слово работа. Требуется много времени и сил, пока удается добиться результата оптимизации.

Поисковая оптимизация является одним из самых распространенных способов продвижения сайта. Те, кто выполняют эту работу, называются оптимизаторами, специалистами по продвижению или SEO специалистами.

Как работает поисковая машина

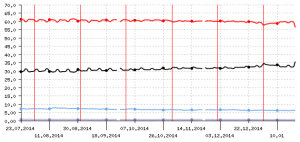

Когда-то Яндекс уверенно лидировал в русскоязычном интернете. Красный – Яндекс, черный – Google, голубой – Mail.ru. По данным LiveInternet.

Поисковая машина, точнее ее поисковый робот приходит на страницу по найденной им ранее ссылке и скачивает в базу данных всю страницу целиком. Найденные на странице ссылки поисковый робот посетит в свой следующий визит на сайт. Робот ходит не часто. Например, робот Яндекса появляется на сайтах по три-четыре раза в месяц, если это только не новостной сайт.

Затем (обычно, в течении нескольких дней) специальная программа делает подробный анализ скачанной страницы. Алгоритм анализа поисковой системы держится в секрете. Но точно известно, что алгоритм очень сложный, учитывает тысячи факторов, имеет элементы обучаемости (с помощью операторов) и, похоже, до конца не понятен уже даже самим создателям. Результат анализа загруженных страниц называется поисковым индексом и представляет собой базу данных, по которой и происходит поиск.

Раз в несколько дней происходит обновление поискового индекса. В Яндексе это обновление происходит это примерно раз в семь дней. Гугл обновляет поисковый индекс ежедневно.

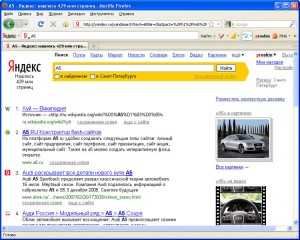

Рисунок показывает, насколько сложна поисковая оптимизация. По некоторым запросам можно получить неожиданные результаты.

Пользователь заходит на страницу поиска и набирает искомое сочетание – поисковый запрос. Поисковая машина ищет в индексе сайты, на которых встречается данное сочетание. Страница с результатами поиска называется поисковой выдачей. Все найденные сайты сортируются по соответствию запросу – ранжируются по релевантности. В этой сортировке и состоит сама суть работы поисковой системы.

Многим оптимизаторам хотелось бы знать алгоритм сортировки поисковой выдачи, но, вообще-то, знать его не обязательно, и уж точно это знание не дало бы им в руки никаких серебряных пуль. Судите сами – алгоритм меняется раз в пару месяцев. Перед его сменой десятки, а то и сотни операторов занимаются обучением этой программы (Яндекс это называет “Матрикснет”. Позиция каждого сайта в выдаче зависит не только от самого сайта, но и от позиций остальных сайтов. Даже зная алгоритм, никто точно не сможет воспроизвести его работу, для этого пришлось бы построить вторую поисковую систему, загрузить в нее ровно все загруженные сайты и обучить ее точно так же. Те, кто смог смоделировать работу Гугла теперь называют себя Яндексом. 🙂 Шучу, но в каждой шутке, есть только доля шутки. 😉

Про алгоритм ранжирования поисковой выдачи (алгоритм определения релевантности) точно известно, что он состоит из трех частей.

1. Анализ самого сайта или внутреннее ранжирование. Анализируются сотни параметров: как часто различные слова упоминаются в обычных абзацах, в заголовках, в подписях к рисункам, в тексте ссылок, какие слова выделяются курсивом или жирным текстом, насколько слова близко расположены к началу страницы и т.д.

2. Анализ входящих ссылок или ссылочное ранжирование – анализ внешних ссылок, т.е. ссылок с других сайтов. Ссылочное ранжирование стало признанием разработчиками того факта, что поисковые машины у них получаются слишком глупыми, чтобы самим понять, насколько хорош текст на сайте. Поэтому они полагаются на мнение, высказанное на других сайтах. Высказыванием мнения они считают размещение ссылок, ведущих на сайт. Чем больше ссылок, тем авторитетнее сайт. Ссылки с авторитетных сайтов еще авторитетнее.

3. Учет поведенческих факторов. Это еще одно свидетельство неспособности поисковых машин оценить качество страниц сайта. Вместо того, чтобы делать оценку релевантности страницы, поисковые машины наблюдают за поведением пользователей на этой странице. Источником информации о поведении является подглядывание за пользователями через их собственные браузеры (например, Яндекс-Браузер или Гугл-Хром), через плагины для браузеров (Напр., Элементы от Яндекса или дополнительная панель от Mail.ru), через счетчики на сайте (например, Яндекс Метрика), а также анализ поведения пользователя на странице поисковой выдачи. Если пользователь задержался на сайте надолго, то считается, что сайт его заинтересовал. Если пользователь сразу закрыл найденную страницу и снова вернулся на поисковую машину, то предложенный сайт не является релевантным запросу.

Как работают специалисты по поисковой оптимизации

На самом деле, у алгоритмов поисковых машин есть еще одна значимая составляющая – оптимизаторы. Не надо делать вид, что по коммерческим запросам хотя бы один сайт смог попасть на первую страницу Яндекса без участия оптимизаторов.

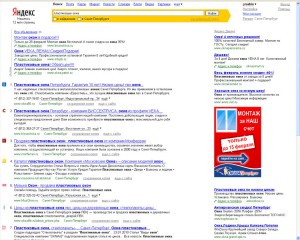

В выдаче по запросу “пластиковые окна” нет ссылок про устройства пластиковых окон, нет стандартов, нет руководств по монтажу и изготовлению – только, где купить. Большая область человеческих знаний свелась только к торговле.

Такие страницы – это как будто рейтинг оптимизаторов.

Как бы не “улучшались” алгоритмы поисковой машины, на первых страницах всегда будут те сайты, у которых лучше сделана поисковая оптимизация. Поэтому в среде SEO есть поговорка, что “поисковая выдача становится релевантной только благодаря оптимизаторам”.

Так как же работают оптимизаторы, не зная алгоритмов поисковых машин? Попытаюсь объяснить простыми словами.

Поисковая машина для внешнего наблюдателя выглядит, как черный ящик. “Черный ящик” – это термин в теории обработки сигналов. У черного ящика есть сигнал на входах и на выходах. На входе интернет – на выходе поисковая выдача. Давно известно, что, чтобы описать работу черного ящика, не надо знать его устройство. Надо знать, как меняется его выход, если на вход подавать разные сигналы.

Оптимизаторы постоянно ставят опыты. Они воздействуют на входы поисковой системы и следят за результатом. Один вход – наполнение сайта, второй вход – внешние ссылки на сайт, третий – поведение пользователей сайта (да, его тоже можно менять), и еще один вход поисковой системы – ее служба поддержки (существует только у Яндекса).

Эти эксперименты довольно медленные и трудоемкие. Для некоторых экспериментов создаются сотни сайтов, да и в повседневной работе хороший оптимизатор постоянно экспериментирует на своих собственных проектах.

Анализ эффективности поисковой оптимизации

Как можно оценить эффективность продвижения, выполняемого и планируемого? Ну, раз продвижение – это увеличение трафика, то надо поделить затраты (деньги и время) на результат (поисковый трафик). Получится показатель стоимости целевого посетителя через поисковую оптимизацию.

Не смотря на очевидность такого подхода, он не очень удобен. Поэтому чаще используют отчет о позициях сайта по продвигаемым запросам.

Договор на поисковое продвижение включает в себя перечень ключевых слов, по которым сайт должен быть на первых позициях.

При этом ключевые слова обязательно надо оценить с точки зрения их востребованности – приложить к договору не только список запросов, но и частоты этих запросов. Тогда весь договор надо оценивать по суммарному количеству запросов в месяц. От этой суммы будет зависеть трафик целевых посетителей на сайт.

Измерить поисковый трафик довольно просто любым популярным счетчиком. Требуйте от вебмастера установки счетчика на сайт и он-лайн доступа к отчетам. Например, очень удобен счетчик Яндекс Метрика. Он умеет выделять поисковый трафик.

Планировать поисковую оптимизацию сложнее, чем оценивать. Приблизительно можно считать, что трафик будет равен суммарной частоте запросов, умноженной на вероятность клика в пару процентов.

При планировании поискового трафика надо учесть, что результаты оптимизации появятся через пять-шесть месяцев. Слишком медленно поисковые машины индексируют тексты и ссылки в интернете.

Цена посетителя при поисковой оптимизации часто оказывается сравнимой или даже выше, чем при баннерной рекламе, при всей ее неэффективности и дороговизне. И тем более, поисковый трафик оказывается в несколько раз дороже, чем при контекстной рекламе. Прибавьте к этому еще то, что поискового трафика приходится ждать по несколько месяцев, а время – тоже деньги!

Часто заказчики себя утешают тем, что эффект от поисковой оптимизации должен бы сохраниться на длительное время, что можно делать поисковое продвижение пол года, а потом прекратить.

Это было верно несколько лет назад, но совсем не верно сегодня. Теперь сайт уходит с первой страницы выдачи через один-два месяца. Ну а чего еще можно ожидать, если у конкурентов работают оптимизаторы, и им заказаны именно те места, которые занимает ваш сайт?! К тому же покупные ссылки существуют, только пока за них платят. Так что после окончания цикла работ по улучшению поисковых позиций приходится платить за “поддержание” достигнутых результатов.

Прочитайте также статью о формировании цен на поисковое продвижение, чтобы узнать подробнее, какие могут быть варианты оплаты по договорам на SEO.

Если статья не ответила на Ваши вопросы, то Вы можете задать их в комментариях ниже или или обратиться к нам за консультацией.

Если честно, немного прифигел от таких цен за оптимизацию, 80 рублей за посетителя это непозволительно дорого.

Статья интересная, но под конец все опять свелось к серым и черным методам оптимизации.

По мне так оптимизация сайта должна быть такой, что:

1) Пользователю самому удобно и понятно становится работать с сайтом. Чтобы сайт удовлетворял цели, которую преследует пользователь. Это самое главное.

2) Сайт предоставлял поисковику правдивую информацию о том, каким содержимым он обладает. Без клоакинга, без перенасыщения ключевыми словами, без всей этой мишуры.

При этом title, description, h1 и ЧПУ заполнены так, чтобы

а) В выдаче поисковики их использовали для сниппета

б) Пользователь, видя сниппет, быстро понимал, что это именно та страница, которая ему нужна

3) Эффект от этих действий был долгосрочным и в последствии только улучшал позиции сайта

Остальное все — это трата времени, денег и порча своей кармы обманом клиента, поисковика и пользователя.

Возможно таким подходом много бабла не срубишь. Возможно в топ по высокочастотным словам никогда не попадешь.

Но на своем небольшом опыте скажу, что сайты, которые я оптимизировал такими методами твердо держат верхние позиции без моего дальнейшего участия. Иногда, конечно, бывает, что какая-нибудь контора перебивает первые позиции, но обычно это ненадолго, видимо 80 рублей за клик для них многовато =D

Еще замечу, Рунет сплошь наполнен статьями о том, как поднаебать поисковики всеми возможными способами, а англоязычные ресурсы уже давно ушли от этого и дают советы, как сделать свой сайт лучше для пользователя в первую очередь.

А Вы замечали как советы вебмастерам дает гугл и как дает яндекс. Яндекс в основном советует чего не делать что бы не попасть под санкции, а гугл дает советы как улучшить свой сайт.

Причем оба из них дают абсолютно туманные и не прозрачные советы “за все хорошее” или “против всего плохого”. Так что сотрудничества с вебмастерами и у одного, и у другого не бывает.

Оптимизация должна быть, в первую очередь, эффективная. 🙂

Если посетители и заказы есть, значит оптимизация правильная!